OFF #14 | La newsletter pour reprendre le contrôle

Janvier 2024

Voulez-vous connaître l’heure de votre mort ?

Prédire et éliminer l’incertitude. Tel est l’un des principaux objectifs du big data.

La quantité de traces que produit notre activité numérique (y compris lorsque nous sommes apparemment déconnectés) est utilisée pour alimenter des modèles ayant pour objectif d’anticiper tout type de risque. Ce principe peut s’appliquer au climat, au crime, aux maladies, aux risques naturels, aux résultats académiques ou sportifs, au divorce, au rendement d’un travailleur ou au comportement d’un consommateur, etc.

Dans cette première édition d’OFF en 2024, nous soulevons les questions éthiques que pose l’application de ce principe aux affaires humaines. Est-ce souhaitable ? Quelles sont les conséquences en termes de liberté individuelle et de justice sociale ? Nous allons explorer à quoi ressemblerait un monde dans lequel la vie des personnes serait gouvernée par la prédiction de leurs futures actions.

Principes et utilisation

L’IA est capable de détecter des tendances, des schémas et des corrélations entre différents phénomènes à partir d’une multitude de données, d’une façon qui n’est pas à la portée du cerveau humain. En regardant le passé et le présent, elle tente d’établir la probabilité que quelque chose ait lieu dans le futur.

Ceci peut être très utile quand on l’applique au contrôle de l’environnement, pour prédire la probabilité qu’un incendie ait lieu ou l’évolution d’une épidémie, ou encore pour effectuer la maintenance prédictive d’avions et remplacer les pièces qui ont une probabilité d’être défectueuse.

Mais le big data peut également être exploité pour anticiper le comportement humain et prétendre éliminer les risques qu’il présente. Dans les grandes lignes, on compare un individu à partir de son activité passée avec des profiles similaires et on déduit la probabilité qu’il agisse comme d’autres personnes qui partagent des caractéristiques ou des comportements semblables.

Connaître l’heure de votre mort

ll y a quelques semaines, une équipe de chercheurs danois et américains a fait connaître Life2vec, une IA capable de prédire les conditions de la mort d’un individu avec une probabilité de 78,8 %. Pour cela, elle a analysé les profils économiques, sociaux et sanitaires de 100 000 personnes âgées de 37 à 67 ans, la moitié desquelles était décédée dans les quatre ans suivants. Ces données ont alimenté un algorithme ayant vocation d’anticiper quand et comment une personne allait mourir, en fonction de son profil.

Ceci pourrait s’avérer utile pour prévoir des problèmes de santé ou pour mettre en place des mesures visant à réduire les inégalités pouvant affecter un groupe social, mais serait également précieux à une compagnie d’assurance afin de modifier ses conditions ou à une banque pour refuser un prêt immobilier.

Les géants technologiques s’intéressent depuis longtemps à ce domaine. Google a également développé un modèle à partir de milliers de données de patients, permettant de calculer la probabilité de sortir d’un hôpital vivant une fois admis.

Demande rejetée

Le big data peut également être exploité pour prédire des risques en apparence plus triviaux. L’an dernier, Airbnb a déployé une IA qui analysait des centaines de signaux (sans préciser lesquels) pour détecter des réservations associées à un risque élevé que les locataires organisent une fête durant leur séjour.

Imaginez que vous êtes en train de faire appel à un service et qu’on vous le refuse sans que vous sachiez pourquoi. Techniquement, sans une régulation adéquate, on pourrait appliquer cela dans le secteur financier et pour guider la décision d’accorder ou refuser un crédit. Au lieu de se fonder sur des critères directement liés à la situation financière de l’individu, l’IA pourrait analyser des milliers de données issues de sa géolocalisation, ses habitudes d’achat ou de santé, et de cette boîte noire sortirait un verdict, avec toutes les discriminations et l’arbitraire qu’on peut imaginer.

Prisonniers du passé et de ses pairs

Un autre domaine où l’IA pourrait faire fi d’une analyse humaine est la justice, par exemple pour accorder ou refuser la liberté conditionnelle à un détenu en fonction de sa probabilité supposée de récidiver. Ici aussi, la méthode consistant à établir des corrélations statistiques pour formuler une prédiction pourrait entraîner tout type de biais : un bas revenu, l’appartenance à une minorité ou d’autres données sans relations directes avec les faits auxquels devrait se tenir la décision pourraient déterminer une décision.

Un monde dans lequel nous serions enfermés dans ce type de modèle pourrait déterminer nos vies pratiquement dès la naissance. L’avocate espagnole Paloma Llaneza, autrice du livre Datanomics, cite l’exemple d’un programme en étude au Royaume-Uni qui aurait pour but d’établir dès la jeune enfance s’il vaut la peine ou non d’investir dans l’éducation d’un enfant, sur la base de son comportement. La base idéologique de ce type d’approche attribue une capacité nulle à l’individu d’évoluer et de se libérer des schémas dans lesquels elle-même les enchaîne.

Le risque de prétendre éliminer le risque

Imaginez que vous êtes en train de jouer à un jeu et qu’on vous révèle dès le début le moment où vous allez perdre. Seriez-vous capable d’en profiter ou votre tête serait-elle accaparée par cette prédiction ? Qu’arriverait-il si un pronostique sur votre futur était incorrect et que vous aviez conditionné votre existence à cette croyance sans fondement ? Agirait-il comme une prophétie auto-réalisatrice ou maintiendriez-vous une marge pour échapper aux statistiques ?

Dans un monde où les décisions sur notre futur individuel était régi par des corrélations extraites à partir du big data, il est possible qu’Einstein n’eût jamais obtenu de bourse pour son doctorat ou que toute une série de grand génies n’eût pas bénéficié d’une seconde chance avant de se révéler. L’autorité accordée aux prédictions pourrait condamner injustement des personnes parce qu’elles rentreraient dans des profils dessinés par une IA. Et cette absence de liberté qu’elle confère aux individus serait elle-même destructrice de liberté.

Souvent, le moteur de ces modèles est notre propre curiosité. Les tests génétiques proposés par des compagnies telles que Ancestry ou 23andMe qui révèlent l’origine ethnique et géographiques sont de plus en plus populaires aux Etats-Unis, mais le coût de livrer son propre ADN sur un plateau pourrait être plus élevé que nous l’imaginons.

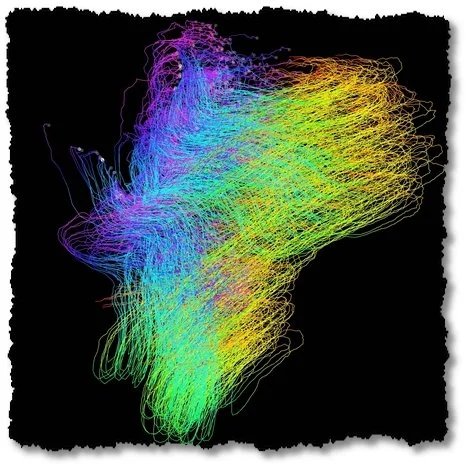

Carte sur laquelle le client de 23andMe découvre ses origines en fonction de ses gènes

Un bracelet connecté qui mesure les constantes vitales et les pas que nous effectuons pourrait aider à anticiper des maladies mais il permet également de nous identifier aussi précisément qu’une empreinte digitale et peut-être cela n’en vaut-il pas la peine.

Une éminence médicale m’a dit un jour que la médecine préventive était très bien, mais que la maladie que la médecine était capable de traiter le moins bien était l’anxiété, laquelle elle pouvait participer à générer. Avoir l’illusion de connaître notre avenir, considérer ces prédictions comme quelque chose de probable, et permettre à des tiers d’utiliser ces informations pour orienter leurs décisions nous concernant pourrait non seulement nous enfermer dans cet hypothétique destin, mais paradoxalement, dégrader nos vies.

Peut-être devrions reconnaître que le risque est une composante essentielle de la vie-même.

Suscríbete a OFF, la newsletter para retomar el control.

Una vez al mes, propongo una reflexión sobre una faceta específica de la influencia de la tecnología digital en nuestras vidas para ayudar a entender mejor la transformación acelerada de nuestro día a día.